Huggingface CEO:阿里Qwen-2成全球开源大模型排行榜第一,中国处于领导地位

来源:GiantPandaCV | 发布时间:2024-07-12

摘要:阿里开源的Qwen2-72b-Instruct在OpenLLM Leaderboard2中夺冠,巩固了其在全球开源大模型领域的领导地位。Qwen2提供多种模型类型和宽松许可,满足不同需求。其性能卓越,尤其在诗词创作、代码理解等方面表现出色。Qwen2-57B-A14B-Instruct采用创新MoE架构,提升训练和推理效率。Qwen2的发布推动了全球开源大模型的发展,为开发者提供强大工具。

前言

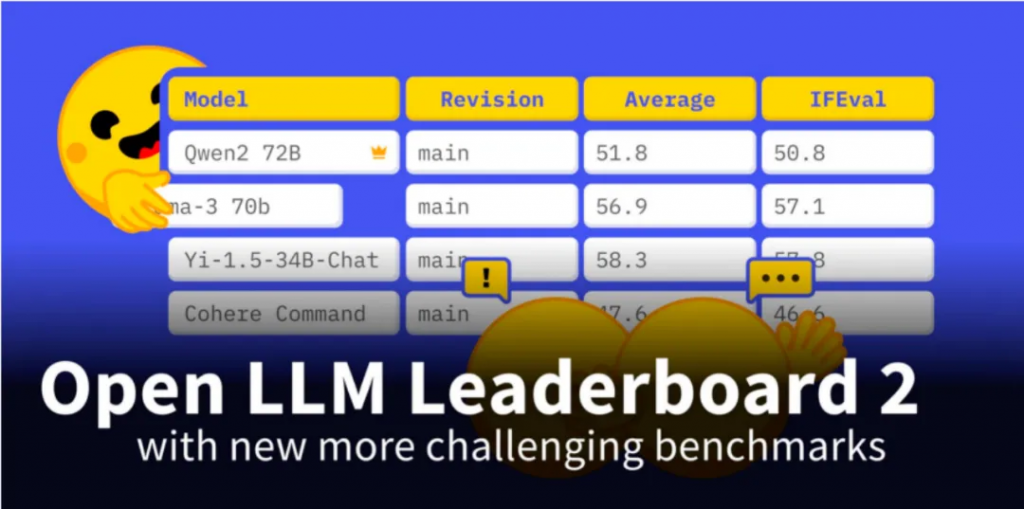

HuugingFace的CEO Celm官宣了一个新的LLM排行榜OpenLLM Leaderboard2,阿里的Qwen2-72b-Instruct版本成为这个新排行榜上的第一名。此前,在 OpenLLM Leaderboard1 上阿里的 Qwen2-72b-Instruct 开源之后就一直是第一。可以说,Qwen2目前算是真正的开源大模型国产之光了。

他表示,为了提供全新的开源大模型排行榜,这次使用了300块H100对目前全球100多个主流开源大模型,并在BBH、MUSR、MMLU-PRO、GPQA等基准测试集上进行了全新评估。据数据显示,全新排行榜的前10名竞争非常激烈,很多都是当过之前排行榜第一名的高手。其中,阿里开源的4款大模型傲视群雄,充分说明中国对全球开源大模型的重要贡献以及领导地位。

Clem更是直接表示:“Qwen2是王者,中国在全球开源大模型领域处于领导地位。”

Qwen2开源之后我个人也在围绕 Qwen2 做一些周边的工作并有一些直观的感受。例如Qwen2-57B-A14B-Instruct这一个 Qwen2 中的 MoE 模型在私有数据集中就表现很好,在4k或者8k长度下做微调的时候初始Loss已经很低了,在0-1之间,效果很好。不过在外推到32K并做SFT的时候Loss会升高到8左右,原因是Qwen2的模型是在4k或者8k的数据上训练然后直接外推的,但经过一段时间的训练Loss也能下降得很好。

Qwen2开源亮点

我这里盘点一下本次Qwen2开源的一些关键亮点吧。

Qwen2开源的诚意很足,在HF上一下放出了0.5B,1.5B,7B,57B,72B 4种类型的Dense模型以及57B-A14B的MoE模型。并且每种类型的模型都放出了Pretrain和Instruct两种版本。其中0.5B,1.5B,7B可以满足端测AI速度的需求,而57B,72B则能满足云端需要更强劲性能的需求。另外,Qwen2的许可非常宽松,个人开发者或者做应用的创业公司可以做的事情其实就更多了。

除了诚意,开源大模型最重要的就是性能。在OpenLLM Leaderboard1以及最新的Leaderboard2上,Qwen2-72B-Instruct版本都是Top1。而其它更小参数量的Qwen2模型也基本是同一量级的SOTA级别,但因为参数量变小的问题相比于Qwen-72B-Instruct会有性能上的减弱,我们开发者需要灵活选用性能和速度平衡的模型解决问题。

除了上面提到的系列Pretrain和Instruct模型外,注意到Qwen2在HF上还提供了数个其它格式的模型如AWQ,GPTQ-Int8,GGUF等。这些是源于Qwen2对接了大量的推理框架,使得Qwen2的模型部署极度容易。即使是个人开发者微调了模型也很容易部署,可以在Qwen2的github仓库找到它对HF,ollama,vLLM,llama.cpp框架的支持。

Qwen2 MoE架构和Mixtral架构的区别

我个人更关心Qwen2-57B-A14B-Instruct这个模型,这也是Qwen2的MoE架构模型。观察它的代码可以发现它和Mixtral架构类似,不过在SeleAttention部分的q, k, v映射矩阵加入了Bias。另外在MoE部分引入了Shared Experts以及Shared Experts Gate。从训练Infra角度来说,我们仍旧可以沿用Mixtral MoE的训练架构和并行设置,只需要做几个轻微的改动就可以对齐精度,迁移是非常方便的。

Qwen2-72B-Instruct效果展示

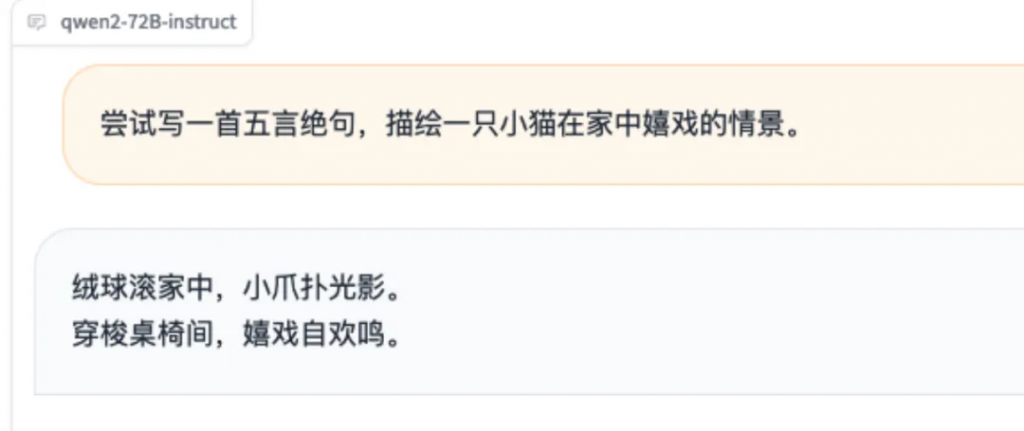

我在HuggingFace的Qwen-2开源地址上测试了几个我实际用到的文创,代码以及CUDA相关的问题,感觉效果非常不错,这里贴一下截图。也给大家附上地址体验:https://huggingface.co/spaces/Qwen/Qwen2-72B-Instruct Space

在诗词方面,Qwen2的指令跟随能力确实很强。因为我之前测试过好几个其它的大模型,它们对五言和七言的格式并不理解,而Qwen2输出的格式一直是正确的。

我又问了一个问题,我这里并没有提示这个代码是哪个框架的代码,Qwen2直接猜出了这行代码是PyTorch框架下的并且给了我正确的方法。

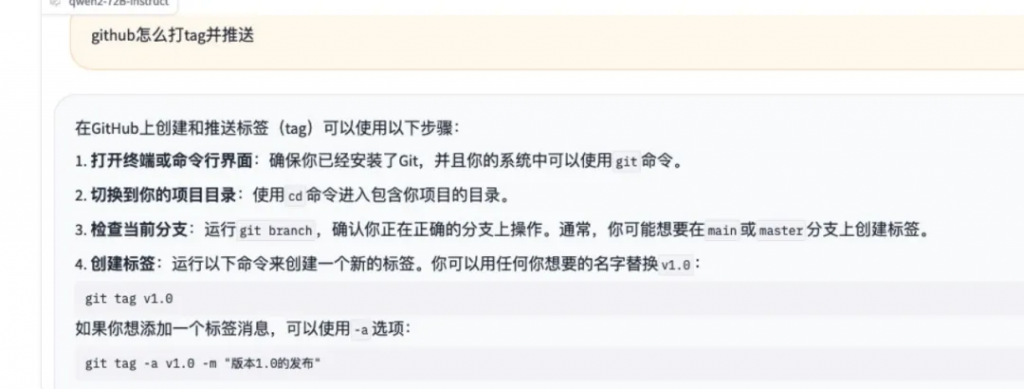

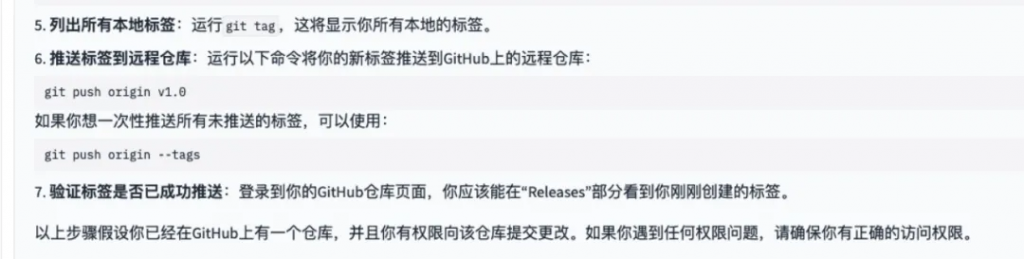

我这里又问了一个 github 工具类的问题,它的回答也是非常正确全面。

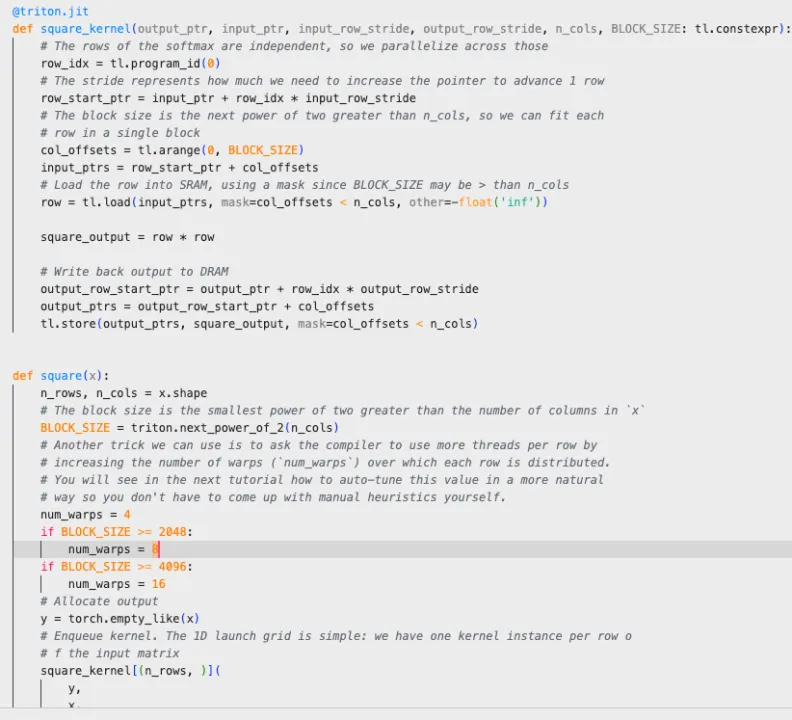

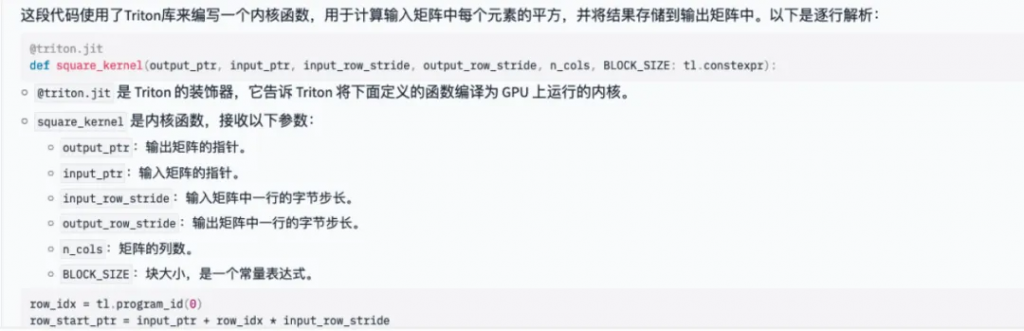

我这里是要求Qwen2解析一下下面的Triton写的矩阵开方的kernel(prompt为:帮我详细解析一下这个Triton代码,最好是能逐行解析一下 代码,用中文回复。接上代码 ):

… 后面还有很多代码详解我就不贴了,这些解释对于辅助理解代码是很棒的。

基于这些贴上来的我的实际需求的回答来看,Qwen2指令跟随能力很强,回答的质量也比较高,作为个人助手或者在垂直领域继续微调的基座都是非常棒的。

总结

从个人对Qwen2的榜单,评测以及训练适配等角度来看,Qwen2目前应该是个人以及做大模型应用的AI公司首选的开源大模型之一。同时也很高兴看到国产的开源大模型被全世界认可,无论是这次开源的Qwen2还是前段时间开源的DeepSeek2,我们都能感受到国产大模型的高速发展。