微软CEO愿景:用个性化AI服务赋能全球80亿人

来源:微软科技 | 发布时间:2024-09-09

摘要:由Copilot开启的“Copilot时代”已经到来,在Microsoft Ignite大会上,微软CEO萨提亚·纳德拉围绕AI,展示了从芯片、开发工具、数据、到应用等各个层面的创新。我们希望通过这些持续创新,让全球80亿人都能够享受到更加个性化的教育、医疗等智能服务,让不可能成为可能。

由Copilot开启的“Copilot时代”已经到来,在Microsoft Ignite大会上,微软CEO萨提亚·纳德拉围绕AI,展示了从芯片、开发工具、数据、到应用等各个层面的创新。我们希望通过这些持续创新,让全球80亿人都能够享受到更加个性化的教育、医疗等智能服务,让不可能成为可能。

自ChatGPT首次问世,仅过去短短一年的时间,这真让人难以置信。然而在这一年里,我们所取得的成就、所见证的创新速度都令人叹为观止。

如今,我们已进入了AI的新阶段。我们不再满足于抽象地谈论创新,而是开始关注产品制造、部署、AI安全和实际生产力的提升。我们站在时代的转折点上,毫无疑问,副驾驶时代已经来临。

我们与大家分享了最新数据,展示Copilot在实际应用中带来的生产效率提升。我们以开放的视角,深度研究和理解Copilot对创造力和生产力的深远影响,而结果令人叹为观止:Copilot使任务完成速度得到显著提升,这在各个工作流程中产生了连锁反应,带动了整体效率的提升。

我们坚信,Copilot将成为全新的用户界面,它不仅帮助你接触世界的知识,理解组织的智慧,更重要的是,它将成为你的得力助手,帮助你基于这些知识采取行动。

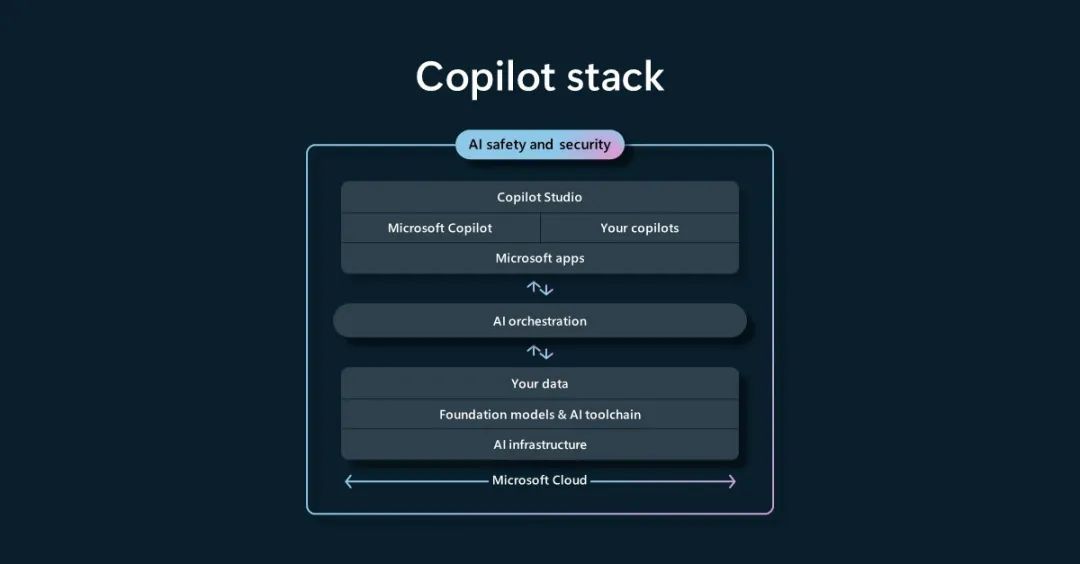

因此在Ignite大会上,我们在堆栈的每一层引入100项更新,共同助力实现这一美好愿景。 我们为每个组织提供的端到端Copilot堆栈,全面覆盖基础设施、基础模型、工具链、数据等各个环节,当然也包括Copilot本身。

Copilot 堆栈

在我们所宣布的内容中,我强调了五个关键主题:

AI 基础设施

我们首先从AI的基础设施层开始,Azure不仅仅是一个简单的云平台,更是我们眼中的“全球计算机”,其基础设施覆盖超过60个数据中心区域,领先于其他供应商。

作为全球计算机,我们还需要成为世界上最好的跨异构基础设施的系统公司。我们与整个行业的合作伙伴密切合作,从电力到数据中心、机架、网络、核心计算,以及AI加速器,整合最佳的创新能力。在这个新的AI时代,我们正在重新定义我们所有产品的内涵。

在构建数据中心时,微软努力采用可再生能源,如今我们已经成为全球最大的可再生能源购买者之一。自2013年以来,我们已经采购了超过19吉瓦的可再生能源。

我们正在与生产商合作,引入来自风能、太阳能、地热能和核聚变的新能源。我们的目标是到2025年,数据中心使用的能源将100%来自零碳能源。

同时,我也很高兴地宣布Azure Boost正式发布。这个新系统将服务器虚拟化进程卸载到专用的软件和硬件上,能够极大地提高网络以及远程和本地存储的吞吐量,使得Azure成为高性能工作负载的最佳选择,同时也加强了安全性。

我们不仅依赖于自己的研发力量,更积极借鉴行业的创新技术,与AMD、英特尔等合作伙伴共同为用户带来最佳体验。

作为超大规模企业,我们深知工作负载的重要性,并从中汲取经验、全方位优化整个技术堆栈,从能源消耗到芯片层面,最大限度地提高性能和效率。正是得益于这种深入的反馈循环,我深感荣幸能推出我们首款自主研发的定制CPU系列——Azure Cobalt,其首发产品为Cobalt 100。

Azure Cobalt

Cobalt是微软自主研发的首款CPU,专为微软云量身打造。作为一款64位、128核的ARM架构芯片,Cobalt在所有云服务商中的速度表现也是非常优异的。目前,它已经助力Teams、Azure通信服务以及Azure SQL等多个产品的部分功能实现飞跃式发展。

在AI加速器方面,我们也正在与整个行业的伙伴广泛合作,致力于将Azure打造成为训练和推理的首选云平台。

我们与英伟达建立了深厚的合作关系,借助其GPU技术在云中成功构建了强大的AI超级计算基础设施。

值得一提的是,在最近一次MLPerf基准测试中,Azure有10000个H100 GPU的提交量,是此前纪录的三倍之多,性能优于其他云平台。而在全球超级计算机500强榜单中,Azure是公有云中性能强大的超级计算机,总排名位列第三。

在构建超级计算机以训练这些大型模型时,InfiniBand为我们带来了独特优势。而今,我们更进一步宣布,将在我们的产品组合中引入英伟达最新的GPU AI加速器H200,以支持更大规模的模型实例化,同时保持相同的延迟。

此外,我们还推出了Azure Confidential GPU VM的预览版,确保敏感数据集的AI模型能够在云端被安全运行,这一创新成果由微软与英伟达共同设计。

另外,我也很激动地宣布,AMD的旗舰产品MI300X AI加速器将登陆Azure,带来更多AI优化虚拟机的选择,进一步提升大型模型的运算速度。我们已经在MI300X上启动并运行了GPT-4,并向特定客户提供抢先体验权限。

然而,我们的探索不止于此。我们始终致力于汇聚系统各领域的专业知识,并为用户呈现来自合作伙伴及微软的卓越创新。

正因如此,微软推出了一款完全自主研发的AI加速器——Azure Maia。它专为运行云AI工作负载而设计,如LLM训练和推理。这款芯片采用5纳米工艺制造,拥有1050亿个晶体管:

Azure Maia

然而,我们的创新并未止步于芯片。由于AI的功率需求与其他云服务截然不同,我们为AI设计了一个完整的、端到端的Maia机架解决方案。AI计算工作负载对冷却和网络密度的需求更高,为此我们设计了与芯片热特性相匹配的冷却单元,并引入了机架级别的闭环液体冷却系统,以提高散热效率。

这种架构允许我们将Maia机架集成到现有的数据中心基础设施中,而无需进行大规模的新建工程。而且,我们已经在多个微软自家的AI服务中进行了测试,包括GitHub Copilot。我们计划先在微软内部的工作负载中部署Maya加速器,然后再扩展到第三方的工作负载。这种芯片的多样性不仅是微软技术的核心,也是我们能够为全球领先的基础模型以及所有AI工作负载提供稳定支持的关键。

基础模型与AI 工具链

接下来,让我们进入堆栈的下一层:基础模型。这些模型的存在,要归功于我们上述讨论的先进技术。

生成式AI模型的范围十分广泛,从需要Azure中最强大的GPU支持的、拥有数万亿参数的大型语言模型(LLM),到数十亿参数、专注于特定任务的小型语言模型(SLM)。不论需求是什么,我们都能提供适合的模型,帮助你打造专属的AI应用,同时确保成本、延迟和性能都得到优化。

我们与OpenAI开展了深度合作,OpenAI正努力推动AI模型领域的创新发展,而我们非常荣幸能够成为其合作伙伴,共同助力AI技术的进步。

对于客户,我们始终坚守一个简单的承诺:每当OpenAI推出技术创新,我们都会将其整合到Azure AI中。因此,我们已将OpenAI的最新模型,包括GPT-4 Turbo以及GPT-4 Turbo with Vision,都引入了Azure OpenAI服务。

GPT-4 Turbo不仅价格更为亲民,还提供结构化的JSON格式及扩展提示功能。它将在Azure OpenAI服务中以预览版的形式提供,这些新模型的定价将与OpenAI保持一致。

我们也全力支持开源,希望把最好的开源模型选择带到Azure,并以负责任的方式做到这一点。目前,我们的模型目录已是业内最广泛的选择,而且还在持续添加更多模型到目录中。我们再次针对开源模型发布了一项重要更新:在Azure中,我们新增了“模型即服务(MaaS)”的功能。这意味着你无需配置GPU,就能轻松访问大型模型,从而更专注于开发工作,而不必分心于后端运营。

我们很自豪能与Meta合作进行这一项目。你可以使用自己的数据微调Llama 2,以帮助该模型更好地理解你的业务领域,从而成更准确的预测。我们希望支持每一种语言、每一个国家的模型。我们正与Mistral合作,将他们的优质模型作为一项服务提供,同时也与Group 42合作,将阿拉伯语模型Jais作为一项服务提供。

在开源领域,小型语言模型(SLMs)的出现让人兴奋。微软热爱SLMs,尤其是由微软研究院开发的Phi,这款模型在高度专业化的数据集上表现优异,甚至可以与比其大50倍的模型一较高下。

虽然Phi 1.5只有13亿个参数,但在常识、语言理解和逻辑推理等基准测试中表现出了先进的性能。

我们隆重推出了Phi 2,这是Phi 1.5的升级版,它在所有这些基准测试中表现出了更好的性能,同时保持相对较小,拥有27亿个参数。Phi 2是开源的,很快大家就能在我们的目录中使用到它。

拥有这些模型后,工具的支持也必不可少。Azure AI Studio提供了完整的生命周期工具链,助力开发者构建、定制、训练、评估和部署最新的下一代模型,内置的安全工具也为开发过程保驾护航。

我们在Azure AI Studio中做的另一件事是将其扩展到任何端点,首先从Windows开始。你可以自定义最先进的SLMs,并结合常见的开发场景模板,快速将AI能力融入应用中。

之前我提到了微软与英伟达的合作,我们携手创新,致力于将Azure打造为训练和推理的最佳云平台。我们的合作深入到整个技术堆栈,为AI开发者提供的一流解决方案。在Ignite大会上,我们宣布扩展合作伙伴关系,将英伟达的生成式AI Foundry服务引入Azure。

你的数据

现在,让我们来谈谈数据,这可能是最重要的考虑因素,因为在某种意义上,没有数据就没有人工智能。

Microsoft Fabric将所有数据以及分析工作负载,集成到一个体验中。Fabric是自SQL Server以来我们推出的非常大的数据产品,预览版的反响非常惊人。我非常高兴地宣布Microsoft Fabric正式发布。

微软科技

微软还宣布了一项名为“镜像”的新功能。无论是云数据仓库还是数据库,无论是Cosmos DB、Azure SQL DB、Mongo DB还是Snowflake,你都可以无障碍地将它们添加到Fabric中,实现数据的统一管理和应用。这不仅适用于微软的云,也同样适用于任何其他的云。

Teams

现在让我们进一步谈谈在AI时代如何重新构想我们所有的核心应用程序,包括Teams。

我们对Teams的愿景始终是将协作、聊天、会议和呼叫所需的一切集中在一个地方。全球超过3.2亿的用户已经证明了Teams在提升生产力和连接团队中的价值。

就在10月,我们发布了全新的Teams,这是我们为AI时代重新构想的产品。新的Teams速度提高了一倍,使用的资源减少了50%,节省了时间,并帮助你更高效地协作。我们还简化了用户体验,让你能够用更少的点击次数,轻松完成更多的工作量。它也是下一代 AI 驱动体验的基础,改变了我们的工作方式。它可以在Windows和Mac上使用,当然也可以在所有手机终端上使用。

Teams远不止是一个通信和协作工具。它是一个集合点,一个灵活的平台,将各种业务流程直接整合到工作流中。目前在Teams商店里,已经有超过2000个应用,其中Adobe、Atlassian、ServiceNow、Workday等应用每月的活跃用户数量超过100万。各个行业的公司已经在Teams中创建了145000个定制的业务应用程序,以满足他们的特定需求。

对于Teams的理解,我们应该认识到“在场”的重要性。事实上,“在场”才是最终的关键应用。基于这一理念,我们将Mesh的强大能力引入到Teams中,重新定义了员工如何通过各种设备,无论是PC、HoloLens还是Meta Quest,来聚集和连接的方式。我非常激动地告诉大家,Mesh将在明年1月份全面上线。

Copilot

让我们来到堆栈的最顶端, Microsoft Copilot。

我们的愿景很清晰:成为每个人的工作副驾驶。我们坚信在未来的工作中,Copilot将无处不在,无所不能。Copilot是一个贯穿所有微软产品的体验,它能理解你在网络和设备上的使用情景。当你工作时,Copilot会在合适的时机为你提供所需的功能。

以内置的搜索功能为例,Copilot能够为你提供网页的上下文理解,为你提供更精准的搜索结果。搜索正在变革,而微软愿意为此全力以赴。

我们的企业版Copilot还增加了商业数据保护功能,只需使用你的Microsoft Entra ID登录即可享受这一服务,而且所有符合条件的Entra ID用户都可以免费使用。

不久前,我们正式发布了Copilot for Microsoft 365。它不仅局限于某个特定的应用,还能够跨越整个Microsoft Graph进行推理和理解,将自身无缝集成到Teams、Outlook、Excel等应用中。同时,Graph中所有可用的企业知识和操作,Copilot也都能够轻松获取。

在Copilot的扩展性上,我们支持插件的开发,同时我们对OpenAI上周公布的GPTs感到极度兴奋,因为这项新技术为大众提供了一种定制ChatGPT的可能,让它在工作或家庭环境中能发挥更大的作用。未来,你将能在Copilot中同时使用插件和GPTs,以此来打造专属于你自己的AI助手。

当然,每个组织和每个人的需求都是独特的,因此你需要为特定需求、数据、工作流程和安全要求定制您的Copilot。我们宣布推出Copilot Studio,这是一个全新的平台,旨在帮助用户定制符合自己需求的Copilot。

我们已经运用这种模式,将Copilot的功能扩展至各个不同的角色和领域。

对于开发者,GitHub Copilot正在将自然语言转化为编程语言,帮助他们提高55%的编程速度。

对于SecOps团队,Copilot正在帮助他们以机器速度应对威胁。不仅如此,我们还将为身份管理、端点安全以及风险与合规管理人员添加插件。

对于销售人员,Copilot随时在线,帮助你达成更多的交易。无论你是通过电子邮件洽谈,还是Teams会议来协商,只要将Copilot与你的CRM数据结合,无论这些数据来自Salesforce还是Dynamics 365,都能让你的客户交互更富成效。

对于客户服务团队,我们推出的Copilot for Service将帮助客服座席更快地解决问题。它在客服日常使用的工具中提供准确的知识和情境参考,并且可以直接嵌入到座席的桌面应用程序中。

随着Copilot的不断扩展,一个全新的Copilot生态系统正在崭露头角。如今,包括Confluence、Jira、Mural、Ramp和Trello在内的数十家独立软件开发商,已经为他们的应用构建了Copilot插件,同时客户们也在创建自己的业务插件,以提高工作效率、获得更深入洞察。你不仅可以在Copilot中访问这些插件,还可以在我们的应用程序中展示它们。

最后,我想谈谈两个关键领域的创新轨迹:AI与混合现实,以及AI与量子计算。

首先,AI不仅仅是将自然语言作为输入。虽然语言输入是起点,但AI的能力已经远超这一范畴。想象一下,当现实世界成为你的提示词和输入界面时会发生什么?

请注意,不仅仅是你的声音,还有你的手势,甚至你的眼神,都可能成为新的输入方式,这对于使用Dynamics 365的一线工作人员来说是多么变革性的体验。

第二个领域是量子计算与AI的融合。如今科学发现的关键在于对自然现象进行复杂的模拟,无论是化学、生物学还是物理学,都依赖于高性能计算。AI技术能够对这些模拟进行仿真,进而减少搜索空间,提高运算效率。

而这正是我们使用Azure Quantum Elements所做的事情,就像大型模型可以生成文本一样,你将能够生成全新的化合物。科学家们可以利用这一工具设计出独特的新型分子,为开发可持续化学品、药物、先进材料或电池提供更多可能。

与此同时,我们在量子计算方面也取得了显著的进步。我们深知,量子计算将成为加速所有模拟过程的关键。因此,我们宣布与Photonic达成战略合作,旨在扩展全栈量子方法的应用,共同推动量子网络的发展。

针对生成式AI,微软从三个维度面向企业级用户提供了业务支持和服务:Azure AI服务与功能、Microsoft Copilot智能副驾驶、以及Microsoft Copilot Studio等系列开发工具与平台服务,我将其称为微软生成式AI的三部曲。

微软生成式AI三部曲覆盖了企业级用户AI基础设施、基础大模型、数据智能平台、AI开发平台与工具链等从云到边缘的各种应用场景。换句话说,微软认为用户有多种拥抱生成式AI的方式,无论是OpenAI这样的基础大模型,还是各种开源的边缘小模型;无论是大模型对接,还是自己训练专属的模型,无论云上,还是线下,微软都提供了支持和服务。

都知道OpenAI是微软在大模型领域的战略合作伙伴,OpenAI的旗舰模型GPT-4o在Azure平台上开发训练,并已经加入Azure AI Studio,透过API可以实现其服务调用,所谓近水楼台,但是与此同时,微软也在不断拓展其“模型即服务(Model as a Service)”的覆盖范围,也对Coherence、Databricks、Deci、Meta、Mistral AI、Snowflake等多种大模型提供了支持。微软还宣布加强与开源社区Hugging Face合作,为的是将更多开源模型引入Azure AI服务和Azure AI Studio开发工具。但这也仅仅微软生成式AI的冰山一角。

陶然表示:生成式AI的未来,不在于训练更多的大模型,更为关键的还是将通用大模型和企业进行有机的结合,Copilot智能副驾驶是微软面向企业级用户提供的一种形式的服务。

透过Microsoft Copilot智能副驾驶,用户让生成式的基础大模型,访问和处理由Office、Teams、邮件、会话等软件应用所积累的数据,在这个基础之上,提供各种生成式AI的分析、推理和服务。针对非微软的应用软件数据,微软Copilot了数据的接口。

“很多用户希望能够结合企业数据对于大模型进行调优,鉴于企业数据量限制,以及缺乏优质标注数据,其实这种调优的效果非常有限,难以对大模型产生影响。因此,类似RAG (Retrieval-Augmented Generation,检索增强的生成)这样的技术,将是一种比较好的结合私有数据的思路。” 陶然说。

“会有用户并不满足于此,会有用户希望训练自己模型,为此,微软提供了Copilot Studio等多种AI工具,让开发者能够构建属于自己的智能副驾驶。其中, GitHub Copilot在过去两年中,已成为应用最广泛的AI开发者工具,拥有 180 万付费用户。” 陶然补充说。

GitHub Copilot 智能副驾驶是微软和第三方合作伙伴开发的工具,新增功能允许开发者、企业通过其偏好的服务(如 Azure、Docker、Sentry 等)应用开放和体验。 此外,针对不断变动的数据,微软推出了Microsoft Fabric技术服务,其中,全新的实时智能(Real-Time Intelligence)可以帮助数据分析人员,获得简单的低代码/无代码体验,其代码丰富的用户界面也会让专业开发者受益。例如,Dener Motorsport车队一直在使用 Microsoft Fabric 支持实时分析、存储和报告,从而保证最佳性能,并使赛车保持良好的维修状态,让驾驶员更安全。

在边缘侧,微软开发的AI小语言模型(SLMs)Phi-3 系列也发布了一款新的多模态模型——Phi-3-vision,并已可在 Azure 中使用。Phi-3 模型功针对个人设备进行了优化, 能够输入图像和文本,并接收文本回复。如此一来,用户可以针对图表、或特定图像提出各种开放式的问题。

康容表示:按照规模法则(Scaling Laws),如今AI技术大约每六个月就可以实现能力翻倍,在今年的Build全球开发者大会上,围绕Azure AI和Copilot智能副驾驶,目的就是为了让更多企业的智慧化转型注入创新活力。

微软将与Cognition携手 ,这是一家应用型人工智能实验室,致力于开发端到端软件的代理,其自主AI软件代理 Devin,能够帮助用户完成代码迁移,和现代化项目迁移等内容。作为双方协议的一部分,Devin 将由微软智能云Azure 提供支持。

2024年度《工作趋势指数报告(WTI)》显示,AI正在成为现代生产力必不可少的组成部分。在中国市场, 91%的受访劳动者已经将AI用于日常工作,82%的管理者表示更看中求职者的AI技能。也许这里的数字略显乐观,但是不可否认的是,这个趋势已经是人所共知。