英伟达市值一夜大涨16%,跻身全球第四

来源:澎湃新闻 | 发布时间:2024-02-27

市值仅次于微软、苹果、沙特阿美。

2月22日晚,英伟达市值一夜大涨16.4%达到1.96万亿美元,创下历史新高,并一举超越谷歌和亚马逊跻身全球第四,仅次于微软、苹果、沙特阿美。

英伟达单日市值增加2770亿美元,约等于1.5个英特尔,这也是美股历史上个股最大单日市值增长。

2月22日英伟达刚刚公布了截至今年1月28日的2024财年第四季度财报。在财报公布前一天,英伟达股价下跌4.35%,出现今年年内最大单日跌幅;财报公布当天,股价再跌2.85%。

但英伟达近乎满分的答卷一夜之间填满了投资者的信心。该季度英伟达营收为221亿美元,同比增长 265%,环比增长22%。市场预期为204.1亿美元;利润方面,净利润为123亿美元,同比增长了769%,按美国通用会计准则下,本季度毛利率达76%,市场预期75%。

财报电话会上,英伟达首席执行官黄仁勋称,对AI所依赖的计算能力的需求仍然是极其巨大的,“全球范围内,企业、行业和各国的需求都在激增。”

英伟达的增长势头为何如此强劲?

1.收入利润大涨,数据中心狂飙

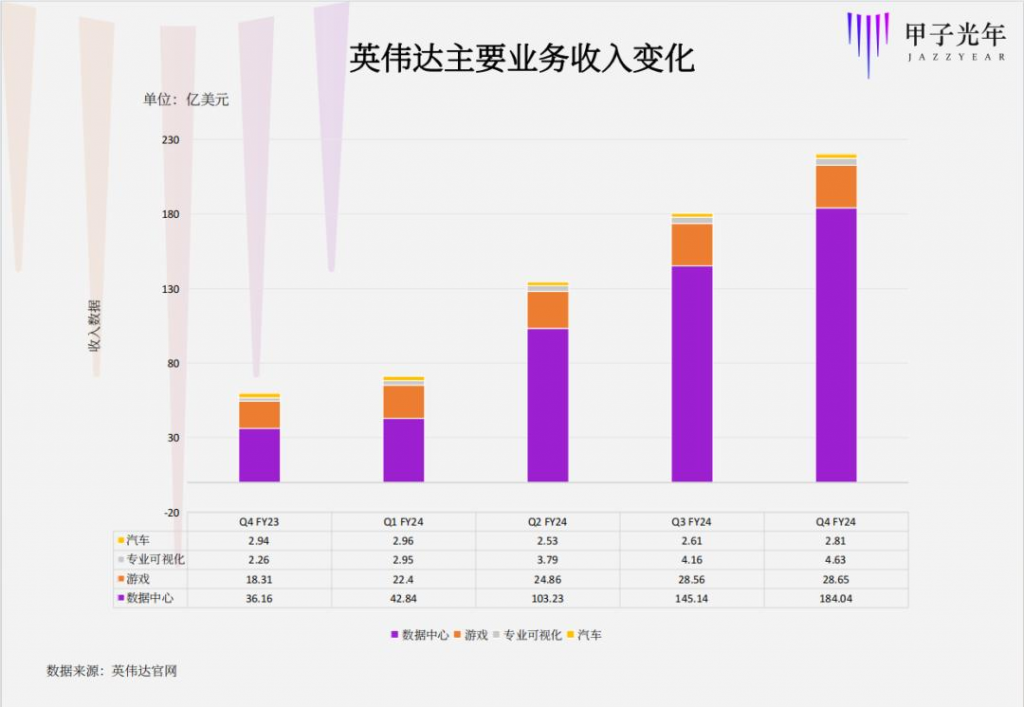

英伟达有数据中心、游戏、专业可视化、汽车四大业务,先看一下具体的业绩表现。

数据中心

数据中心业务已经成为英伟达的顶梁柱。

财报显示,第四季度营收达到创纪录的184亿美元,环比增长27%,同比增长409%。全年收入增长217%,达到创纪录的475亿美元。

财报电话会上,英伟达高管解释道,第四季度数据中心的增长是由跨行业、案例和地区的生成方式人工智慧和语言模型的训练和推理所推动的。其中,约40%来自人工智能推理。

第四季度,大型供应商占英伟达数据中心收入的一半以上,支持内部工作负载和外部公有云客户。

其中,消费互联网公司是英伟达最大的客户类别之一。从搜索到电子商务、社交媒体、新闻和视频服务以及娱乐的公司都在使用人工智能优化产品体验,甚至直接影响营收。Meta便在最新季度财报中表示,更准确的预测和广告商业绩的改善有助于其收入大幅增长。

22日早上,英伟达还宣布与Google合作优化其最先进的新Gemma语言模型,以加速其在云端、数据中心和PC中NVIDIA GPU上的推理。

针对中国地区,在美国政府10月份实施出口管制法规后,英伟达数据中心收入大幅下降。第四季度,中国数据中心收入占数据中心收入的中个位数百分比,并预计第一季度将保持在类似的范围内。

同时,英伟达透露已经开始向中国市场运送不需要许可证的替代品。

游戏

同为英伟达发家业务,相比于数据中心的迅猛涨势,游戏业务的表现有些中规中矩。

第四季度,游戏业务营收为29亿美元,环比持平,同比增长56%。全年收入增长15%,达到104亿美元。

最近一次闪光时刻是在CES上,英伟达发布了GeForce RTX 40 Super系列 GPU 系列,起价599美元,支持最新的NVIDIA RTX™ 技术,包括 DLSS 3.5光线重建和NVIDIA Reflex。

此外,AI PC是本届CES上的一枝独秀,英伟达自然也没有缺位。英伟达宣布为其超过1亿台RTX AI PC的安装基础提供生成式AI功能,包括用于加速大型语言模型推理的Tensor-RT™ LLM ,以及让用户使用自己的内容个性化聊天机器人的技术演示Chat with RTX 。

英伟达还推出了NVIDIA Avatar Cloud Engine的微服务,允许游戏和应用程序开发人员将最先进的生成式AI 模型集成到不可玩的角色中。

专业可视化

第四季度,专业可视化业务营收为4.63亿美元,环比增长11%,同比增长105%。全年收入增长1%,达到16亿美元。

财报电话会显示,本季度的连续增长是由RTX Ada架构GPU的丰富组合持续增长所推动的。企业正在更新其工作站,以支持与生成型人工智能相关的工作负载,例如数据准备、LLM微调和检索增强生成。

这些推动需求的关键垂直行业包括制造业、汽车和机器人技术。汽车行业也是NVIDIA Omniverse的早期采用者,因为该行业寻求将工厂和汽车从设计到建造、模拟、操作和体验的工作流程数字化。在CES上,英伟达宣布Brickland、WPP和ZeroLight等创意合作伙伴和开发商正在构建Omniverse 支持的汽车配置器。

汽车

第四季度,汽车业务营收为2.81亿美元,环比增长8%,同比下降4%。全年收入增长21%至11亿美元。

汽车业务是黄仁勋继游戏、数据中心之后被寄予厚望的第三大核心业务。但从今年的表现来看,似乎不尽如人意。

财报透露,其后续产品NVIDIA DRIVE Thor通常专为视觉Transformer设计,可提供更多AI性能,并将广泛的智能功能集成到单个AI计算平台中,包括自动驾驶和停车、驾驶员和乘客监控以及AI驾驶舱功能,并将明年上市。

同时,本季度有多家汽车客户发布公告,理想汽车、长城汽车、吉利旗下高端电动汽车子公司ZEEKR以及小米电动汽车均发布了基于NVIDIA的新车。

云服务收入

此外,「甲子光年」发现,英伟达新布局的云业务也有很大起色。

财报显示,软件和服务产品也取得了巨大进展,第四季度的年化收入达到了10亿美元。

英伟达也宣布NVIDIA DGX Cloud将扩大其合作伙伴名单,将亚马逊AWS纳入其中,加入Microsoft Azure、Google Cloud和Oracle Cloud的行列。DGX Cloud用于NVIDIA自己的AI研发和自定义模型开发以及NVIDIA 开发人员。它将CUDA生态系统带给NVIDIA云服务商合作伙伴。

2.黄仁勋说了什么?

问:为什么数据中心业务暴涨?

黄仁勋:我们正处于两大全行业转型的开始阶段。

第一个是从通用计算到加速计算的转变。通用计算正开始失去动力。您可以从云服务商的扩展和许多数据中心(包括我们自己的通用计算中心)中看出,折旧时间从4年延长到6年。当您无法像以前那样从根本上显著提高其吞吐量时,就没有理由更新更多 GPU。所以你必须加速一切。这是 NVIDIA 一段时间以来一直在开拓的领域。通过加速计算,您可以显著提高能源效率,可以将数据处理成本大幅降低20倍,这是一个巨大的数字。

当然还有速度。这种速度令人难以置信,以至于我们实现了第二次全行业转型——生成式人工智能。请记住,生成式人工智能是一种新的应用,它正在启用一种新的软件开发方式,新类型的软件正在被创建,这是一种新的计算方式。你无法在传统的通用计算上进行生成式人工智能。你必须加速它。

第三,它正在催生一个全新的行业。我们现在有一个关于人工智能生成的新型数据中心,一个人工智能生成工厂,它需要原材料,也就是数据。它用NVIDIA构建的这些AI超级计算机对其进行改造,并将它们变成极其有价值的Token。这些Token是人们在ChatGPT或Midjourney上体验到的,或者如今的搜索也因此得到了增强。现在,您所有的推荐系统都受到了随之而来的超个性化的增强。所有这些令人难以置信的数字生物学初创企业都在生产蛋白质和化学品,这样的例子不胜枚举。

我们业务的推理部分增长巨大,估计约为40%。训练量在持续,因为这些模型变得越来越大,推理量也在增加。但我们也在向新行业多元化发展。大型云服务商仍在继续建设。还有一个全新的类别,他们是专注于NVIDIA AI基础设施、GPU的云服务商。

您会看到企业软件平台部署人工智能。ServiceNow就是一个非常非常好的例子。你可以看到Adobe,SAP和其他公司。您会看到消费者互联网服务正在通过生成式人工智能增强过去的所有服务,因此他们可以创建更多超个性化的内容。

我们正在谈论工业生成人工智能。现在我们的行业代表了数十亿美元的业务:汽车、健康、金融服务,总的来说,我们的垂直行业现在是数十亿美元的业务。

当然,还有主权人工智能(sovereign AI)。每个地区的语言、知识、历史、文化都不同,他们拥有并希望使用自己的数据,训练它以创建自己的数字智能,并自己提供这些服务。主权AI基础设施正在日本、加拿大、法国等许多其他地区建设。所以我的预期是,在美国、在西方所经历的,肯定会在全世界复制。

去年,我们看到生成性AI真正成为一个全新的应用空间,一种全新的计算方式,一个全新的行业正在形成,这正在推动我们的增长。

问:40%的收入来自人工智能推理?如何衡量的?

黄仁勋:这个数字可能被低估了。一年前,推荐系统——地球上最大的软件引擎——都是基于CPU的。但最近向深度学习和生成式人工智能的迁移确实让这些推荐系统现在直接进入了GPU加速的道路,现在推荐系统的每一个步骤都用到了GPU。

世界上几乎每一家大公司都必须运行这些大型推荐系统。每当您使用ChatGPT时,都会对其进行推理。每当你听说Midjourney以及他们为消费者生成的东西的数量时,当你看到我们与Getty和Adobe的Firefly所做的工作时,这些都是生成模型。一年前,这些案例都不存在。这样的例子还在继续。

问:下一代的产品供应会收到限制吗?

黄仁勋:总体而言,我们的供应正在改善。从晶圆、封装、内存、所有电源调节器到收发器、网络和电缆,以及你所能想到的我们发货的组件列表。人们认为NVIDIA GPU就像一个芯片,但NVIDIA Hopper GPU有35000个部件。它重70磅。我们构建的这些东西真的很复杂。人们称它为AI超级计算机是有充分理由的。如果你曾经看过数据中心的背面,那些系统,布线系统令人难以置信。这是世界上见过的最密集、最复杂的网络布线系统。

然而,每当我们有新产品时,它从0增长到一个非常大的数字,你不能一夜之间做到这一点。一切都是逐步增长的。现在我们正在增加H200的产量,我们无法在短期内合理地跟上需求。

我们正在增加Spectrum-X的产量,这是我们全新的产品,进入以太网领域。InfiniBand是AI专用系统的标配。以太网在Spectrum-X之前,并不是一个很好的扩展系统。但是有了Spectrum-X,我们在以太网的基础上增加了新的功能,比如自适应路由、拥塞控制、噪声隔离或流量隔离,以便我们能够为AI优化以太网。所以InfiniBand 将是我们AI专用基础设施,Spectrum-X将是我们 AI优化的网络。

所以,对于所有新产品,需求总是大于供应。这正是新产品的本质,我们尽可能快地工作以赶上需求。总的来说,我们的供应正在非常好地增加。

问:在需求远远超过供应的时候,你们如何公平地分配产能?

黄仁勋:首先,我们的云服务提供商对我们的产品路线图和过渡有着非常清晰的了解。与云服务商之间的这种透明度让他们有信心知道应该在何时何地投放哪些产品。因此,他们能够根据我们的能力了解到最佳时机,并且知道数量和分配情况。我们尽力做到公平分配,并避免不必要的分配。

当数据中心还没有准备好时,为什么要分配资源呢?没有什么比让任何东西闲置更困难的了。在终端市场方面,我们有一个与OEM、ODM、云服务商以及非常重要的终端市场共同构成的优秀生态系统。

NVIDIA真正独特的地方在于,我们为我们的客户、合作伙伴、云服务商和OEM带来客户。所有这些初创公司——大公司、医疗保健、金融服务、汽车等行业都在NVIDIA的平台上工作。我们直接支持他们。而且,我们经常可以通过向云服务商分配资源的同时,将客户带给云服务商来实现双赢。所以这个生态系统是充满活力的。但在其核心,我们希望公平分配,避免浪费,并寻找机会连接合作伙伴和最终用户。

问:英伟达的客户如何看待他们今天正在进行的NVIDIA投资的长期可用性?今天的训练集群会不会变成明天的推理集群?

黄仁勋:这真的是非常酷的部分。如果您看看我们之所以能够如此大幅度提升性能的原因,那是因为我们的平台有两个特点。一是它是加速的,二是它是可编程的。NVIDIA是唯一一个从最开始,字面意义上的最开始,当CNNs和Alex Krizhevsky、Ilya Sutskever以及 Geoff Hinton首次揭示AlexNet开始,一直到 RNNs、LSTMs、每种RL、深度RL、变换器、每种视觉变换器、多模态变换器,以及现在的时间序列内容。每一种AI的变体,我们都支持它,为我们的堆栈优化它,并将其实现在我们的安装基础中。

这真的是非常了不起的部分。一方面,我们可以发明新的架构和技术,比如我们的张量核心变换器引擎,改进新的数值格式和处理结构,就像我们在不同代的张量核心中所做的那样,同时支持现有的安装基础。因此,我们把所有新的软件算法发明,所有的发明,新的行业模型发明,它们都在我们的安装基础上运行。

另一方面,每当我们看到一些革命性的东西,比如Transformer,我们可以创造一些全新的东西,比如Hopper变换器引擎,并将其实现在未来的产品中。因此,我们同时具备将软件带给现有安装基础并不断改进的能力。所以,随着时间的推移,我们客户的安装基础会因为我们的新软件而变得更加丰富。

另一方面,对于新技术,创造革命性的能力。不要惊讶,如果我们在未来的一代产品中突然实现了大型语言模型的惊人突破。这些突破,其中一些将在软件中实现,因为它们运行CUDA,并将提供给现有的安装基础。因此,一方面我们带领所有人前进,另一方面我们取得了巨大的突破。

问:中国市场业务占数据中心的个位数。未来会继续做中国市场吗?

黄仁勋: 记住,核心问题是,美国政府既希望限制NVIDIA加速计算和AI的最新能力进入中国市场,又希望看到我们在中国市场尽可能成功。当新的限制出台时,我们不得不暂停,以便我们理解这些限制是什么,以一种无法被任何软件黑客攻击的方式重新配置我们的产品。这花了我们一些时间。所以我们重新设定了对中国的产品供应,现在我们正在向中国市场的客户进行样品测试。

我们将尽最大努力在中国市场竞争并取得成功,同时遵守限制的规格。上个季度,我们的业务显著下降,因为我们在市场上暂停了。我们停止了在市场上的发货。我们预计这个季度情况会差不多。但在此之后,希望我们能够去竞争我们的业务并尽最大努力,我们会看看结果如何。

问:英伟达的软件业务收入超过10亿美元,具体构成是怎样的?

黄仁勋:让我退一步,解释一下为什么NVIDIA在软件领域将会非常成功的根本原因。

首先,加速计算在云中真正得到了发展。在云中,云服务提供商拥有非常庞大的工程团队,我们与他们合作的方式使他们能够运营和管理自己的业务。每当出现任何问题时,我们都有大型团队分配给他们,他们的工程团队直接与我们的工程团队合作,我们增强、修复、维护、打补丁加速计算所涉及的复杂软件堆栈。

加速计算与通用计算非常不同。你不是从一个像C++这样的程序开始。你编译它,然后所有的东西都在你的CPU上运行。从数据处理、SQL与结构化数据,到所有图像、文本和PDF(这是非结构化的),再到经典机器学习、计算机视觉、语音、大型语言模型、推荐系统,所有这些都需要不同的软件堆栈。这就是为什么NVIDIA有数百个库。

如果你没有软件,你就不能打开新市场。如果你没有软件,你就不能打开并启用新应用。软件对于加速计算是根本必要的。这是加速计算与通用计算之间的根本区别,大多数人花了很长时间才理解这一点。现在人们明白软件确实是关键。

我们与云服务提供商的合作方式真的很简单。我们有大型团队与他们的大型团队合作。然而,现在生成性AI正在使每个企业和每个企业软件公司都能够拥抱加速计算,当现在拥抱加速计算变得至关重要,因为仅仅通过通用计算已经不可能、也不再可能以任何方式维持提高吞吐量时,所有这些企业软件公司和企业都没有大型工程团队能够维护和优化他们的软件堆栈,使其能够在全世界的云、私有云和本地运行。

所以我们将为他们的所有软件堆栈做管理、优化、打补丁、调整、安装基础优化。我们将它们容器化到我们称为NVIDIA AI Enterprise的堆栈中。我们将其推向市场的方式是,将NVIDIA AI Enterprise视为一个运行时,就像操作系统一样。它是一个人工智能的操作系统。

我们每个GPU每年收费4500美元。我猜测世界上的每个企业,每个在所有云、私有云和本地部署软件的企业软件公司,都会在NVIDIA AI Enterprise上运行,尤其是对于我们的GPU。所以这将很可能随着时间的推移成为一个非常重大的业务。我们已经有了一个良好的开端。而且科莱特提到,它已经有10亿美元的年营业额,我们才刚刚开始。